계절조정을 활용한 전이학습 기반의 자동차 예비 부품 장기수요예측

© 2021 KIIE

Abstract

In this paper, we propose a TSLF methodology, which is a Transfer learning with Seasonal adjustment for Long-term Forecasting. The lack of learning data has been a chronic problem in the field of long-term demand forecasting for automotive spare parts which tends to lead to the over-fitting. To solve this problem, we used transfer learning. Transfer learning is actively used in various industries as a technique for reusing pre-trained models to improve the performance of tasks with small data, but there are no research cases applying it. The main idea is to utilize trends that are highly related to other parts as the source domain, and to migrate the pre-trained network while retaining the feature extraction layer. Experiments show that this method mitigates over-fitting problem and reduces error by 14.85% on MAE and 11.3% on RMSE than the traditional method in the small data set.

Keywords:

Transfer Learning, Demand Forecasting, Spare parts1. 서 론

예비부품(spare parts)은 자동차 판매 후 일정 기간 내에 발생하는 고장으로 인한 수요를 위해 창고에 보관해두는 부품을 의미한다. 기업은 정확한 수요예측에 근거하여 생산, 자재 및 물류 계획을 수립하므로, 예비부품 수요예측은 공급망 관리(supply chain management : SCM)와 물류 운영에 있어 매우 중요하다. 반면, 부정확한 수요예측은 재고의 과잉이나 부족으로 이어지어 기업의 경쟁력을 약화시키고, 재정적 부담을 초래한다. 예비부품의 수요량을 과대 추정할 경우, 창고에 장기 미사용 품목이 늘어나 재고 비용의 증가로 이어지며, 과소 추정할 경우, 부품의 출고가 지연되어 고객 불만족으로 이어진다. 특히, 자동차 산업의 제작자는 품질보증기간 동안 발생한 하자 부품을 교체해주어야 할 의무가 있기 때문에 해당 기간 내 원활한 부품 공급을 위하여 예비부품 수요의 정확한 예측이 요구된다. 하지만, 예비부품은 제품의 생산시점 주문에 의해 결정되는 생산부품(manufacturing parts)과 달리 그 수요를 예측하는 것이 쉽지 않다(Lee and Ha, 2015). 예비부품의 특징은 다음과 같다. 첫째, 자동차는 약 3만 여개의 부품으로 조립되어, 예측이 필요한 예비부품의 종류 수(stock keeping unit : SKU)가 많다(Cohen and Agrawal, 2006). 둘째, 자동차 예비부품은 차량의 유지보수, 사고, 그리고 고장 등 필요한 경우에만 수요가 발생하므로, 영수요구간이 빈번하게 나타나며, 변동성이 큰 무더기(lumpy) 또는 간헐적(intermittent) 수요 패턴을 가진다(Boylan and Syntetos, 2009). 셋째, 자동차가 빠른 시일 내에 운행이 가능하도록 신속한 대처가 필요하다(Murphy et al., 2004). 넷째, 진부화 재고(dead stock)의 위험성이 있다(Pecht et al., 2000).

완성차 업체는 경쟁우위를 확보하기 위해 신차 개발 주기를 단축시키고, 신 엔진, 신 변속 시스템 등의 개발에 주력하기 때문에 생산라인의 변화가 빠르다. 하지만, 모제품의 생산라인 철수 이후에도, 모제품이 시장에 존재하면 예비부품의 수요는 지속적으로 발생하기 때문에(Ha, 2018), 향후 몇 년간 발생하는 수요에 효율적으로 대응하는 것이 필요하다. 부품을 자체 생산할 경우, 철수 전 미래 수요 예측치를 기반으로 장기적인 부품 생산량을 결정하여야 하며, 협력업체에서의 생산일 경우, 제조업자 관점에서 일정 주문량이 충족된 후 한 번에 생산하는 것이 효율적이기 때문에 일시에 확보해야할 부품 구입량 결정을 위해서도 장기간 수요에 대한 예측치가 필요하다(Hong et al., 2001).

기존 자동차 예비부품의 수요예측 연구는 회귀분석 방법(Hong et al., 2001), 시계열 분석 방법(Kang et al., 2014; González Vargas and Elizondo Cortés, 2017), 그리고 머신러닝 방법(Choi, 2014; Kim, 2018)과 신경망 방법(Yi, 2007; Jung, 2016; Henkelmann, 2018)이 있다. 회귀 분석 방법은 예비부품의 수명주기(life cycle)를 모형화하여 장기수요예측에 유용하게 사용된다. 하지만, 간헐적 수요를 가진 패턴에서는 예측 성능이 좋지 못하며 무의미한 예측값을 보이게 되는 경우가 많다(Jung, 2016; Lee, 2018). 시계열 분석 방법은 미래의 수요량을 과거의 수요량과 과거의 예측 오차로 회귀시키는 방법이다. 장기간 예측 시, 자기회귀누적이동평균은 특정 값으로 수렴하거나 동일한 값을 연속적으로 예측하므로(Hyndman and Athanasopoulos, 2018), 장기수요예측모형에 적합하지 않다. 신경망 방법은 간헐적, 그리고 비간헐적(non-intermittent)데이터를 처리할 수 있으며, 전체 수명주기에서 발생하는 변곡점을 파악할 수 있어 장기예측에 적합하다(Dombi et al., 2018).

신경망은 예비부품의 간헐적 수요, 장기예측에 우수한 성능을 보임에도, 자동차 예비부품 분야에서는 제한적인 과거 데이터로 인해 일반화 성능이 확보되지 않는다. González Vargas and Elizondo Cortés(2017)은 신경망의 예측 성능이 테스트 시 크게 저하됨을 보여준다. Henkelmann(2018)의 데이터가 제한적인 예측모형(short-term prediction model : STPM)은 과거에 발생한 높은 수요량에 과적합 된다. 특히, 다수의 미래 시점을 예측하는 장기예측 분야에서는 단기예측에 비해 더 긴 시점의 과거 데이터가 필요하므로, 제한적인 데이터 문제가 더욱 발생하는 분야이다(Kotsialos et al., 2005). 이에 본 연구에서는 어떠한 부품의 수요를 예측하는 데, 그와 유사한 특징을 가진 부품에 대한 사전 지식이 유용하다는 가정을 가지고, 부품의 추세성분의 유사성이 높은 타부품의 사전 지식을 전이함으로써, 기존 신경망 모형의 일반화 성능을 개선한다. 해당 부품만 학습한 모델보다 타 부품의 원자료를 전이학습한 모델의 오차가 평균절대오차(mean absolute error : MAE) 기준 약 5.48%, 평균제곱근편차(root mean square error : RMSE) 기준 약 2.14% 감소하였으며, 계절조정 시계열로부터 추세성분을 전이학습한 모델의 오차가 MAE 기준 약 14.85%, RMSE 기준 약 11.3% 감소하였다.

본 논문은 다음과 같이 구성되어 있다. 제 2장에서는 자동차 예비부품의 수요예측, 장기수요예측 그리고 전이학습 기반의 수요예측에 대한 선행연구를 소개한다. 제 3장에서는 연구에 사용된 방법론에 대하여 서술한다. 제 4장에서는 자동차 회사로부터 수집된 실증 데이터를 가지고 제안한 모형을 실험한다. 마지막으로 제 5장에서는 본 연구의 결론 및 활용방안을 서술한다.

2. 관련 연구

2.1 자동차 예비부품 수요예측

기존 자동차 예비부품 수요예측 연구에는 회귀분석 방법(Hong et al., 2001), 시계열 분석 방법(Kang et al., 2014; González Vargas and Elizondo Cortés, 2017), 머신러닝 방법(Choi, 2014; Kim, 2018), 그리고 신경망 방법(Yi, 2007; Jung, 2016; Henkelmann, 2018)이 있다.

회귀분석 방법은 예비부품의 고장이 특정 확률분포를 따른다고 가정한 후, 고장확률밀도함수(failure probability density function)를 추정한다. 시간에 따른 고장률의 변화에 따라 지수분포, 정규분포, 그리고 와이블 분포가 사용된다. 와이블 분포는 초기고장기간, 우발고장기간, 마모고장기간에 나타나는 고장률의 감소형, 일정형, 그리고 증가형의 패턴을 모형화할 수 있어 예비부품 수명예측에 유용하게 사용된다(Lee, 2018). Hong et al.(2001)은 수요에 영향을 미치는 설명 변수를 찾고, 수요량과의 관계를 함수화한다. 수요량에 영향을 미치는 변수로써 출하된 차량의 수, 등록 및 말소된 차량의 수, 차량의 단종 시점, 그리고 차량과 부품의 수명을 고려하여 단종 시점 이후 부품의 수요를 추정한다(Lee and Ha, 2015).

시계열 분석 방법은 미래의 수요량을 과거의 수요량과 과거의 예측 오차로 설명하는 방법이다. 자기회귀(auto regressive : AR)는 과거의 수요량으로 회귀시키는 모형이며, 이동평균(moving average : MA)은 과거의 예측 오차로 회귀시킨다. 자기회귀누적이동평균(auto regressive integrated moving average : ARIMA)은 자기회귀모형과 이동평균모형이 결합된 모형이다. ARIMA는 선형함수를 가정하여, 실무 데이터에서 나타나는 선형과 비선형이 혼재된 패턴을 예측하기 어렵다(Zhang, 2003). 이에 단일 ARIMA 모형보다 신경망과 ARIMA를 결합한 하이브리드(hybrid) 모형이 우수하다는 실험들이 있다(Díaz- Robles et al., 2008; Pektaş and Cigizoglu, 2013). González Vargas and Elizondo Cortés(2017)는 단순 지수평활법, ARIMA, 신경망, 그리고 신경망과 ARIMA를 결합한 하이브리드(hybrid)모형의 예측 성능을 비교분석한다. Kang et al.(2014)은 간헐적 수요패턴에 특화된 크로스톤 방법(croston’s method)과 홀트-윈터스(holt-winters)을 결합한 모형을 제안한다.

머신러닝 방법으로 의사결정나무(Choi, 2014; Kim, 2018)가 사용된다. 의사결정나무(decision tree)는 자동차 부품 수요에 영향을 미치는 요인들을 고려하여 평균제곱오차가 최소가 되는 분리 기준을 정한 후, 정해진 분류 규칙을 기반으로 수요를 예측한다. Choi(2014)는 마코프 과정(markov process)을 사용하여 사고발생수, 온도, 강수량, 적설량, 그리고 풍속의 미래 시점을 추정한 후, 수요 상태 시퀀스를 예측한다. Kim(2018)은 K-평균 군집분석으로 부품 수요량, 생산대수, 사고건수, 납입율, 그리고 모델등급의 연속형 변수들을 범주형 데이터로 변환한 후, 목표변수인 수요량과의 분류 규칙을 찾는다.

신경망 방법은 다층퍼셉트론 모형(Yi, 2007; Jung, 2016), 순환 신경망 모형(Henkelmann, 2018)이 사용된다. 신경망은 실제 출력과 기대 출력의 차이를 역전파하여 오차가 작아지는 방향으로 가중치를 업데이트한다. Yi(2007)는 자동차 보수용 부품의 수요예측력을 향상시키기 위해 신경망을 사용하여 예측력 향상을 확인한다. Henkelmann(2018)은 수요가 빈번하게 발생하는 부품을 대상으로 최적의 하이퍼파라미터(hyperparameter)를 탐색하고, 신뢰성 검사(plausibility check)와 다운스케일링(downscaling)을 사용하여 과거 데이터가 제한적인 예측모형(short-term prediction model : STPM)을 개선한다.

2.2 장기수요예측

장기수요예측은 기업의 장기공급능력을 전략적으로 계획하여 미래의 수요량과 일치시키는 데 있다. 기업은 예상되는 장기 수요를 기반으로 물류 센터의 증축과 같이 변화시키는데 시간이 오래 걸리는 자원을 사전에 재정비할 수 있다. 단기 예측에 비해 생산에 요구되는 시스템 자체를 계획 가능하다는 점에서 장기수요예측은 필요하다. 장기수요예측에 관한 연구들은 회귀분석 방법(Hong et al., 2001; Dombi et al., 2018), 시계열 분석 방법(Kotsialos et al., 2005; de Oliveira and Cyrino Oliveira, 2018), 그리고 신경망 방법(Nguyen and Chan, 2004; Toque et al., 2017)이 있다.

회귀분석 방법은 부품의 수요와 수요에 영향을 미치는 설명 변수의 관계를 함수화한다. Dombi et al.(2018)는 예비부품의 장기수요가 하나의 곡선과 단기 파동(fluctuation)들로 이루어졌다고 가정한다. 예비부품의 구매수명주기(purchase life-cycles : PLC)를 설명하는 수요 모형(Demand Model Function : DMF)함수를 제안한다. 회귀분석 방법은 예비부품의 수명주기를 모형화할 수 있다. 하지만, 예비부품 수요는 우발적인 사고나 고장으로 인하여 인과 관계를 가진 변수를 규명하기가 어렵고, 기후, 도로 환경, 그리고 운전자 운행 습관 등 다양한 변수에 영향을 받기 때문에 정확한 수식으로 정립하는 데 한계가 있다(Lee and Ha, 2015).

시계열 분석 방법은 직관적이며, 계산 비용이 낮아 다양한 예측 문제에 적용된다. 하지만 추세가 변화하는 변곡점을 파악하기 어려워 예비부품의 장기예측에 적합하지 않다(Dombi et al., 2018). de Oliveira and Cyrino Oliveira(2018)는 배깅(bootstrap aggregating : bagging)방법을 활용하여 자기회귀누적이동평균의 장기예측 성능을 향상시킨다. Kotsialos et al.(2005)는 홀트 윈터스모형과 신경망 모형을 결합한 하이브리드 순방향 신경망(hybrid feedforward multilayer neural networks : hybrid-FMNN)모형을 제안한다. 선형 보간법을 사용하여 소규모 데이터셋에 대한 문제를 해결한다.

장기예측분야에서 신경망 방법은 다중출력이 가능한 다층퍼셉트론을 사용한다(Nguyen and Chan, 2004). 다층퍼셉트론은 미래 예측하고자 하는 모든 구간의 수요를 한 번에 출력하는 직접예측(direct prediction) 구현이 가능하다. 이는 이전 오차가 누적되면서 예측이 진행되는 반복예측(iterative prediction)기법의 한계를 극복한다. 신경망 방법은 예비부품 수명주기에서 발생하는 변곡점을 파악하면서도, 특정 주기 영역 안에서도 안정성 있는 예측을 하므로 장기예측에 적합하다(Dombi et al., 2018). Toque et al.(2017) 여행수요예측을 위해 장단기 메모리 모형과 랜덤 포레스트(random forest) 모형을 비교하여, 장단기 메모리(Long short-term memory : LSTM)성능이 우수함을 성명한다.

<Table 1>은 자동차 예비부품의 수요예측에 사용되는 방법론을 비교한다. 회귀분석방법은 특정 분포를 가정하여 예비부품의 수명주기를 추정하는 모수적 방법이다. 하지만, 데이터가 해당 분포를 따르지 않는 경우, 무의미한 예측값을 보인다. 시계열 분석 방법은 선형 함수를 가정하므로, 비선형이 혼재된 실제 데이터를 추정하는데 한계가 있으며, 장기예측에 적합하지 않다(Dombi et al., 2018). 의사결정나무는 비모수모형이며 간헐적 예측에 사용되기는 하나 그 성능이 신경망과 비교하여 우수하지는 않다(Kaya et al., 2018). 하지만, 결과를 해석하고 이해하는데 용이하여 예비부품의 수요예측(Choi, 2014; Kim, 2018) 또는 장기예측(Ding, 2006)에 사용된다.

본 연구에서는 예비부품의 간헐적 수요, 장기예측에 우수한 성능을 보이는 신경망 모형기반의 장기수요예측 모형을 제안한다. 신경망은 모집단에 대한 특정한 확률분포 가정하지 않는 비모수적(non-parametric) 모형이다. 비모수적 모형인 신경망과 부트스트랩(Bootstrap) 모형이 간헐적 데이터를 예측하는데 뛰어난 성능을 보인다(Van der Auweraer et al., 2017). 이에, 신경망이 예비부품이 가지는 간헐적 수요에 우수하다는 연구결과가 많다(Gutierrez et al., 2008; Kourentzes, 2013; Oh and Kim, 2017; Kaya et al., 2018). 하지만, 신경망 모형의 성능은 데이터의 양과 질에 크게 좌우된다(Witten et al., 2016).

2.3 전이학습 기반의 수요예측

전이학습은 소규모 데이터를 가진 작업의 성능을 향상시키기 위해, 대용량 데이터가 있는 분야에서 훈련된 모델을 재사용하는 학습 기법이다(Torrey and Shavlik, 2009). 무작위로 초기화된 가중치를 사용하는 것보다 초기에 빠른 학습이 가능하고, 학습 결과가 높은 수준에서 수렴한다. 이러한 장점들로 인해 영상 처리(Ghadiyaram et al., 2019), 음성 인식(Jia et al., 2018), 그리고 자연어 처리(Sanh, 2019) 등 다양한 산업계에서 활발하게 사용되고 있다.

전이학습이 적용되고 있는 분야의 대부분이 분류 문제이다. 회귀 문제에서는 특정 주제에 한정되어 연구되고 있으며(Ribeiro et al., 2018), 전력수요예측(Ribeiro et al., 2018; Hooshmand and Sharma, 2019; Jung et al., 2020; Le et al., 2020) 분야에서 활발한 연구가 이루어지고 있다. Ribeiro et al.(2018)은 시간 의존적 특징인 추세와 계절 성분을 제거하여 상관성이 존재하지 않는 서로 다른 빌딩의 전력 수요량의 상관성을 찾는다. Hooshmand and Sharma(2019)는 시계열의 공간적 상관성(spatial correlations)을 추출하기 위하여 컨볼루션 신경망(convolution neural network : CNN)을 사용하여 전이 학습 기반의 전력수요예측모형을 제안한다. Jung et al.(2020)은 도시의 월별 전력 수요를 예측하기 위하여 타겟 도메인(target domain)과의 피어슨 상관계수(pearson correlation coefficients : PCC)가 높은 원천 도메인(source domain) 상위 N개를 사전 학습한 모델을 구축한다. 또한, 상관성이 낮은 원천 도메인을 대량으로 학습한 모형보다 상관성이 높은 원천 도메인을 학습한 모형이 우수함을 보여준다. Le et al. (2020)은 K-평균 군집분석 기법을 사용하여 전이학습 기반의 장단기 메모리모형을 제안한다.

신경망 모형은 예비부품의 간헐적 수요, 장기예측에 우수한 성능을 보임에도, 자동차 예비부품 분야에서는 제한적인 과거 데이터로 인해 일반화 성능이 확보되지 않는다. González Vargas and Elizondo Cortés(2017)은 신경망의 예측 성능이 테스트 시 크게 저하됨을 보여준다. Henkelmann(2018)은 과거에 발생한 높은 수요량에 과적합되는 기존 STPM모형의 성능을 신뢰성 검사를 통해 개선한다. 본 논문에서는 어떠한 부품의 수요를 예측하는 데, 그와 유사한 특징을 가진 부품 수요에 대한 사전 지식이 유용하다는 가정을 가지고, 전이학습의 접근 방식을 사용하여 이를 개선한다. 데이터가 적거나 없는 부품의 신뢰성 추정을 위해 신뢰성 특성(Reliability Characteristics)이 유사한 부품이 활용될 수 있다(Groen et al., 2004). 신뢰성 특성은 예비부품의 구매수명주기(purchase life-cycles : PLC)이며, 시계열의 추세성분이 이를 표현할 수 있다(Dombi et al., 2018). 이에 본 연구에서는 예비부품의 추세성분을 활용하여 유사성이 높은 타부품의 사전 지식을 전이함으로써 기존 신경망의 일반화 성능을 개선한다.

3. 방법론

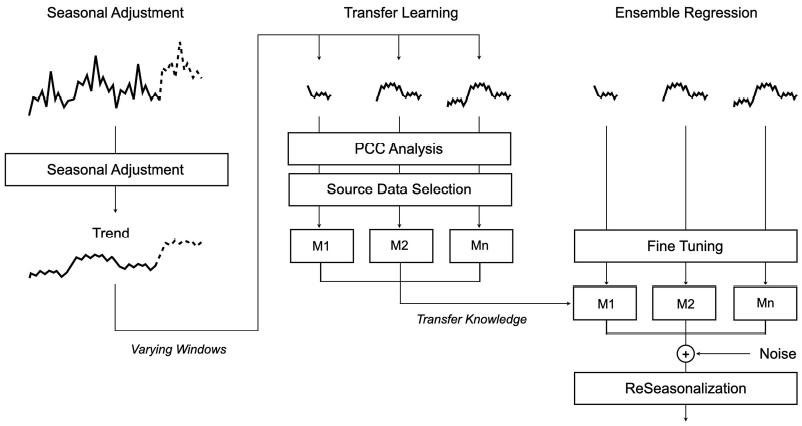

본 논문에서는 계절 조정을 활용한 전이학습 기반의 장기수요예측모형(transfer learning with seasonal adjustment for long-term forecasting : TSLF)을 제안한다. TSLF는 3가지 단계로 구성된다. 계절 조정(seasonal adjustment), 피어슨 상관계수(pearson correlation coefficients : PCC)분석을 활용한 원천 도메인 선택, 그리고 전이학습 기반의 장기수요예측 단계로 구성된다. 전체적인 TSLF 연구 방법은 <Figure 1>과 같다.

3.1 계절 조정

시계열 분해법에는 가법 모형(additive model)과 승법 모형(multiplicative model)이 있다. 본 연구에서는 계절성분의 변동이 시계열의 수준에 따라 일정하다고 가정하여, 가법 모형을 사용한다. 가법 모형의 정의는 Eq. (1)과 같다. 원 시계열 자료를 추세성분T과 계절성분S, 그리고 불규칙성분 I로 분해한다.

| (1) |

추세성분T는 관측 값이 지속적으로 증가하거나, 감소하는 변동을 의미한다. 계절성분S는 주별, 월별 등의 주기마다 반복적으로 나타나는 변동이다. 불규칙성분 I은 시간에 따른 규칙적인 움직임과 무관한 변동이다. 이동평균(moving average)을 이용한 시계열 분해 기법은 추세성분을 먼저 구한 후, 추세가 조정된 자료에서 구한 평균이 계절성분이 된다. 불규칙성분은 원 자료에서 추세성분과 계절성분을 제거한 변동이다. 계절 조정(seasonal adjustment)은 원 자료에서 계절성분을 분리한 성분으로 Eq. (2)와 같다.

| (2) |

계절 조정자료는 추세성분과 불규칙성분으로 구성된다. 추세성분은 신뢰성 특성 중 예비부품의 구매수명주기를 나타내어 유사한 부품을 찾는데 사용될 수 있으므로(Dombi et al., 2018), 추세성분을 기반으로 원천 도메인을 선택한다. 추세성분과 불규칙성분을 학습한 모델로부터 예측된 추세와 잔차를 합하고, 재계절화(reseasonalised)를 통해 최종 예측을 출력한다.

3.2 PCC 분석을 활용한 원천 도메인 선택

전이학습은 소규모 데이터를 가진 타겟 도메인(target domain)에 대한 모델의 성능을 향상시키기 위해 원천 도메인(source domain)으로부터 구축된 사전학습모델(pre-trained model)을 재사용하는 방법이다. 도메인의 정의는 Eq. (3)과 같다. 도메인 D는 과업 T를 수행하는 특징 공간(feature space)과 한계 확률 분포(marginal probability distribution)로 구성된다. 과업의 정의는 Eq. (4)와 같다. 과업 T는 레이블 공간(label space)과 수행함수(predictive function)로 구성된다.

| (3) |

| (4) |

전이학습은 타겟 도메인과 원천 도메인의 레이블 유무에 따라 귀납 전이학습(inductive transfer learning), 변형 전이학습(transductive transfer learning), 그리고 비지도 전이학습(unsupervised transfer learning)로 분류할 수 있다(Zhuang et al., 2021). 귀납 전이학습은 타겟 도메인의 레이블이 존재하는 경우이며, 변형 전이학습은 타겟 도메인의 레이블이 존재하지 않는 경우이다. 비지도 전이학습은 원천 도메인과 타겟 도메인 모두 레이블이 존재하지 않는 경우이다. 또한, 전달하려고 하는 지식(knowledge)에 따라 인스턴스 기반(instance based), 특징 기반(feature based), 파라미터 기반(parameter based), 그리고 관련 지식 기반(relational knowledge based)으로 분류될 수 있다. 본 연구에서 제안한 TSLF모형은 타0겟 도메인 레이블이 존재하고, 원천 도메인으로 학습한 파라미터를 전달함으로써, 파라미터 기반의 귀납 전이학습(parameter-based inductive transfer learning)으로 분류된다.

전이학습을 위해 예측하고자 하는 부품과 유사한 타 부품의 추세 성분을 학습한 파라미터를 전이한다. 부품 간 유사성을 측정하기 위해 피어슨 상관계수를 사용하며, 원천 도메인은 예측하고자 하는 부품과 상관 계수가 0.9 이상인 타 부품의 수요패턴이다. 상관계수의 정의는 Eq. (5)와 같으며, +1 부터 -1 사이의 값을 가진다.

| (5) |

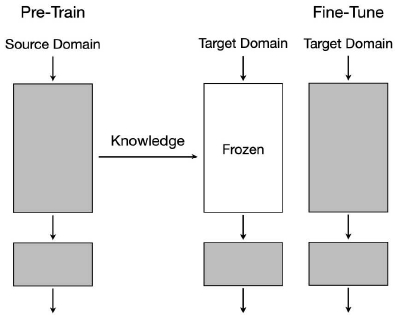

<Figure 2>는 전이학습 과정을 나타낸다. 먼저 원천 도메인으로부터 전체 신경망 모형을 학습한다. 그 후, 특징 추출을 수행하는 네트워크를 동결시킨 채, 소규모 데이터가 존재하는 타겟 도메인으로 분류 층을 학습한다. 마지막으로, 모델의 전체 네트워크를 동결 해제한 후, 미세 조정(fine-tuning)으로 재학습한다.

3.3 신경망 기반의 장기수요예측모형

다층퍼셉트론(multi-layer perceptron: MLP)은 장기수요예측에 활용되는 신경망이다(Al-Saba and El-Amin, 1999). 다층퍼셉트론은 입력층, 은닉층, 그리고 출력층으로 구성되며, 네트워크 내에 순환이 없이 한쪽 방향으로 진행되는 전방향신경망(feed forward neural network)이다. 입력층에는 특징 벡터 를 받기 위한 K개의 노드가 있으며, 출력층에는 출력 벡터 를 위한 C개의 노드가 있다. 다층퍼셉트론의 전체 동작은 Eq. (6)과 같다. 입력층과 은닉층 사이에 비선형 함수인 LReLU(leaky recitified linear unit)함수를 추가한 1개의 은닉층을 갖는 다층퍼셉트론이다. 입력층과 은닉층 사이의 가중치U1과 은닉층과 출력층 사이의 가중치U2로 완전히 서로 연결되어 있는 완전연결신경망(fully connected neural network)이다. 윈도우 크기 K를 갖는 고차원 공간의 시간지연임베딩(time-delay embedding)행렬은 Eq. (7)과 같으며, 신경망 모형의 입력으로 사용된다.

| (6) |

| (7) |

주어진 수요량y와 신경망 출력y'MLP-LF의 차이J를 최소화하는 방향으로 가중치를 갱신되는 다층 퍼셉트론의 학습과정은 Eq. (8)과 같다. ρ는 학습 진도율이다. 학습 진도율이 작으면 학습 속도가 느리고, 크면 학습이 되지 않고 발산할 수 있다. 보통 0.0001에서 0.1 사이의 값을 지정한다.

| (8) |

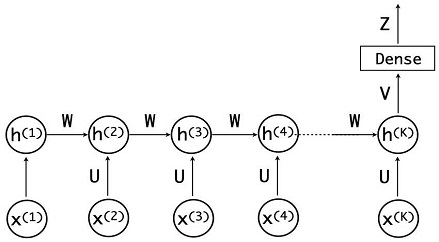

순환 신경망(recurrent neural network : RNN)은 입력층, 은닉층, 그리고 출력층의 세 개 층으로 이루어지기는 하나, 은닉 노드 사이에 순환 에지를 가짐으로써 순차적 구조를 가지는 시간성 데이터를 효과적으로 처리할 수 있다. <Figure 3>은 순환 신경망기반의 장기수요예측모형이다. 입력층과 은닉층 사이의 가중치U, 은닉층과 출력층 사이의 가중치V, 그리고, 은닉 노드 사이의 가중치W로 연결되어 있다. 장기간의 수요 출력을 얻기 위해 순환 신경망 뒤에 다중출력이 가능한 완전연결층을 추가한다. 다중출력이 가능한 완전연결층을 추가함으로써 직접예측기반의 장기수요예측모형을 구축할 수 있다.

순환 신경망의 계산은 Eq. (9)와 같다. 순환 신경망의 은닉층h, 출력층o 계산을 나타내며, 순환 신경망의 최종 출력mRNN 이 다시 다층 퍼셉트론의 입력된다. 이전 오차가 누적되어 예측이 진행되는 반복예측(iterative prediction)에 비해, 미래 예측하고자 하는 모든 구간의 수요를 한 번에 출력함으로써, 더 우수한 예측력을 가진다(Sorjamaa et al., 2007).

| (9) |

장단기 메모리(Long short-term memory : LSTM)는 입력게이트 i, 망각게이트 f, 출력게이트 o를 사용하여 순환신경망의 그라디언트 소멸 문제(gradient vanishing problem)를 해결한다. 장단기 메모리의 전체 동작은 Eq. (10)과 같다. 입력 벡터 x(t)은 입력단 g, 입력 게이트 i, 출력 게이트 o 그리고 망각 게이트 f에 입력된다. 이에 따라 입력층과 은닉층을 연결하는 가중치 U도 입력단과 연결하는 Ug, 입력 게이트와 연결하는 Ui, 출력 게이트와 연결하는 Uo, 망각 게이트와 연결하는 Uf가 있다. 입력단 g와 입력단 게이트 i를 곱하여, 입력단 g를 얼만큼 반영할지를 결정한다. 만약 입력 게이트 i가 0에 가깝다면 입력단 g를 차단하여 이전 입력의 영향력을 더 멀리 전달하는 효과가 있다. 1에 가깝다면 입력단을 그대로 보존하는 역할을 한다. 망각 게이트 f는 이전 정보를 얼마나 잊을지를 결정한다. 1일 경우, 과거의 정보를 많이 사용하게 되며, 0이면 과거의 정보를 망각하는 효과가 있다.

| (10) |

4. 실험 결과

4.1 데이터 전처리

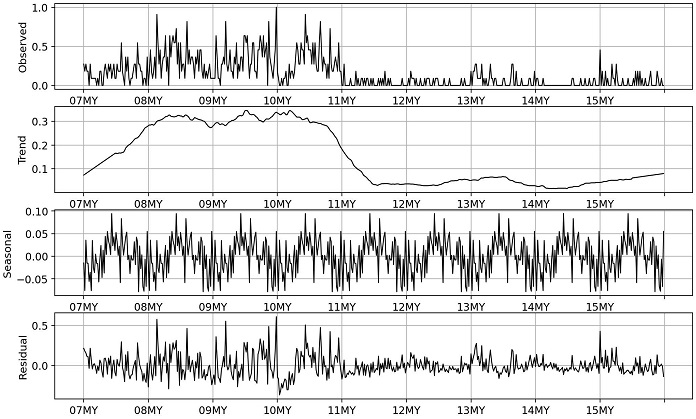

자동차 예비부품 수요는 부품의 고장에 의존하므로(Hong et al., 2001; Lowas and Ciarallo, 2016), 각 시점의 수요량은 차량의 고장자료로부터 주행거리 1,000km(1Tkm)단위로 집계한 고장 건수이다. A차종은 07년식부터 15년식에 대응하는 수요 데이터를 가진다. 매 연식에 해당하는 수요 데이터는 주행거리 60,000km 이내 그리고 사용 기간이 5년 안에서 발생한 수요이다. 학습 데이터와 검증 데이터는 07년식부터 14년식에 해당하는 수요 데이터를 8:2 비율로 나눈 데이터이다. 해당 부품의 학습 데이터 및 검증 데이터의 수는 <Table 3>의 타겟 도메인과 같으며, 윈도우 크기가 클수록, 데이터 수가 적어진다. 테스트 데이터는 15년식 수요 데이터이다. <Figure 4>는 A차종에 장착된 82450부품에 대한 수요 데이터를 나타낸다.

4.2 신경망기반의 장기수요예측모형 선택

신경망기반의 장기수요예측모형으로 다층 퍼셉트론모형, 순환 신경망모형, 그리고 장단기 메모리모형을 기반으로 최적의 은닉 노드의 수와 시계열 윈도우 크기를 탐색한다. <Table 2>는 전체 25개 부품의 추세성분에 대한 검증 데이터와 테스트 데이터 오차의 평균이다. 검증 데이터에서 윈도우 크기 60, 120인 경우, 은닉노드의 수가 20인 LSTM H20 모형이 우수하였으며, 윈도우 크기 180, 240인 모형에서는 MLP H20 모형이 성능이 우수하였다.

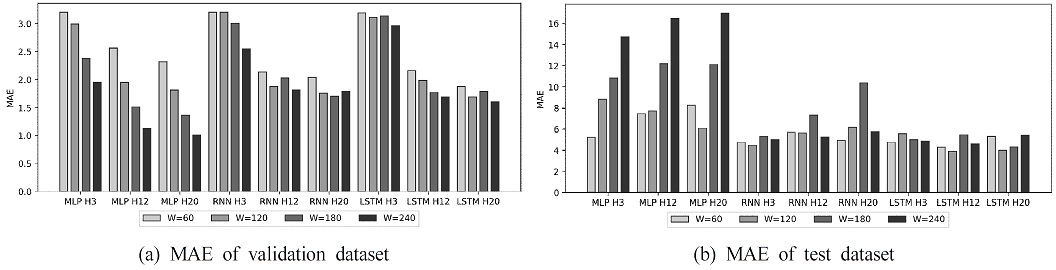

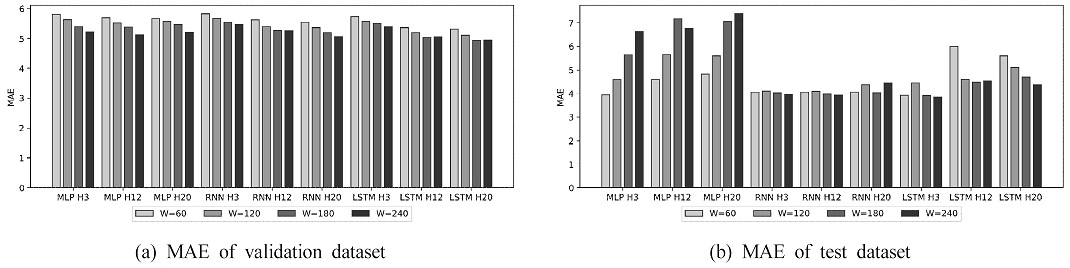

<Figure 5>는 윈도우 크기에 따른 총 9가지 추세성분에 대한 검증 데이터 및 테스트 데이터 MAE 오차를 나타낸다. <Figure 5(a)>에서 검증 데이터는 은닉노드의 수가 클수록 적은 오차를 보이었다. <Figure 5(b)>에서 테스트 데이터는 다층 퍼셉트론 모형보다 장기 문맥을 보존할 수 있는 순환 신경망 계열의 모형의 성능이 우수하였으며, 그 중 장단기 메모리 성능이 가장 우수하였다. <Table 3>은 전체 25개 부품의 불규칙 성분에 대한 검증 데이터와 테스트 데이터 오차의 평균이다. 검증 데이터에서 은닉노드 수가 20인 장단기 메모리모형의 성능이 가장 우수하였다.

<Figure 6>은 윈도우 크기에 따른 총 9가지 불규칙 성분 모형에 대한 검증 데이터 및 테스트 데이터 MAE 오차를 나타낸다. <Figure 6(a)>에서 검증 데이터는 윈도우 크기가 클수록 우수한 성능을 보이었다. <Figure 6(b)>에서 테스트 데이터는 순환 신경망의 성능이 가장 우수하였다.

4.3 원천 도메인 선택 및 하이퍼파라미터

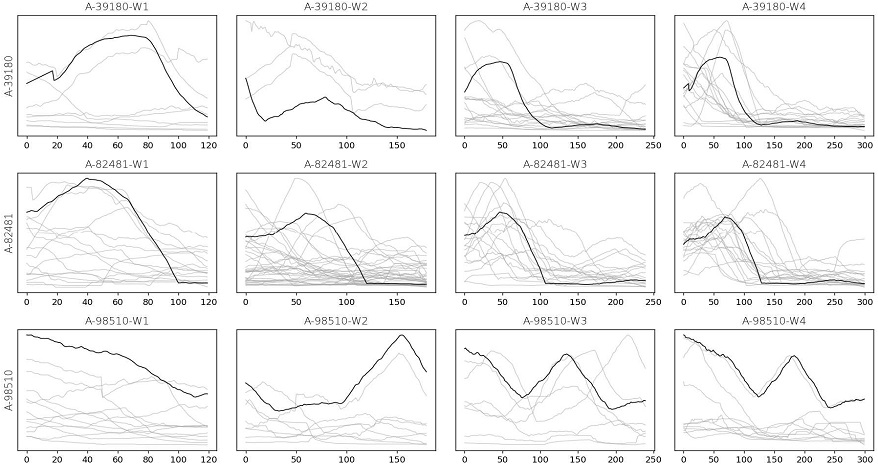

전이학습을 위해 예측하고자 하는 부품의 추세성분과 상관성이 0.9 이상인 타 부품의 추세성분을 원천 도메인으로 정의한다. <Figure 7>은 A차종에 장착된 39180, 82481, 98510부품에 대한 원천 도메인과 타겟 도메인을 나타낸다. 각 행은 동일 부품을 나타내며, 열은 윈도우 크기를 나타낸다. 검은 선은 예측이 필요한 부품의 추세성분으로부터 특정 윈도우 크기에 해당하는 시퀀스 중 일부로 타겟 도메인을 나타낸다. 회색 선은 타겟 도메인에 대응하여 상관성이 높은 시퀀스가 수집된 원천 도메인이다.

해당 부품의 시계열 자료로부터 특정 윈도우 크기를 가진 입력과 60시점의 출력을 가진 신경망의 데이터셋을 구축한다. <Table 4>는 타겟 도메인과 원천 도메인의 학습 데이터 및 검증 데이터의 수이다.

The number of Train and Validation Data of Source Domain and Target Domain with Different Window Sizes

<Table 5>는 실험으로부터 최종 선택된 신경망의 초 매개변수(hyperparameter)이다. 초 매개변수는 학습 과정이 시작되기 전에 사용자가 설정해주는 값을 의미하며, 은닉 노드의 수, 학습 진도율(learning rate), 반복횟수(epoch), 최적화 방법, 그리고 배치사이즈(batch size)가 있다. 은닉 노드의 수는 학습 데이터의 수 대비 입력 노드의 수와 출력 노드의 수를 고려하여 신경망의 과적합이 일어나지 않도록 설정한 후 실험한다. 은닉 노드의 수가 3, 12, 그리고 20 중, 20이였을 시, 검증 데이터 오차가 가장 낮았다. 학습진도율은 원천 도메인을 학습할 경우, 0.01로 지정하였으며, 타겟 도메인을 학습할 경우, 더 적은 0.001의 학습률을 설정하였다. 미세 조정시에는 전체 네트워크의 동결을 해제한 후 학습하므로 과적합에 유의하여 더 적은 학습 속도와 반복횟수를 설정하였다. 반복횟수는 검증 데이터가 10회 이상 향상되지 않을 경우 학습이 조기 종료된다. 최적화 방법은 아담(Adaptive Moment estimation : Adam)방법을 사용한다. 수요예측을 위한 기존 연구에서 Adam 방법이 좋은 추정 값을 찾아준다고 알려져 있다(Henkelmann, 2018). 배치 사이즈는 32로 설정한다.

윈도우 크기마다 검증 데이터의 성능이 가장 우수한 모형을 선택하였다. 윈도우 크기가 60, 120인 경우, LSTM H20 모형이며, 윈도우 크기가 180, 240인 경우 MLP H20모형이다. 원천 도메인으로 학습한 LSTM H20 또는 MLP H20 층을 동결(freeze)시키고, 타겟 도메인으로 완전연결층을 학습시킨다. 마지막으로 적은 학습 속도와 적은 반복횟수를 가지고 타겟 도메인으로 전체 네트워크를 학습한다.

4.4 모델 비교

미래 연식에 대한 부품 수요를 예측하기 위해 회귀분석 방법, 시계열 분석 방법, 머신러닝 방법 그리고 신경망 방법을 비교한다. 와이블 분포를 가정한 회귀분석 방법은 최대우도추정법(maximum likelihood estimation, MLE)을 사용하여 찾은 형상 모수(shape parameter)와 척도 모수(scale parameter)를 기반으로 부품 수요의 확률밀도함수(probability density function)를 추정한다. 과거 데이터로부터 부품의 품질보증기간동안 발생한 총수요의 평균값을 곱하여 최종적인 부품 수요량을 예측한다.

자기회귀누적이동평균(ARIMA)는 자기회귀 모형의 차수(p), 차분 차수(d), 그리고 이동평균 모형의 차수(q)를 모수로 가진다. 계절 자기회귀누적이동평균(SARIMA)는 자기회귀누적이동평균(ARIMA)의 모수와 더불어 계절성 부분의 자기회귀 모형의 차수(P), 차분 차수(D), 이동평균 모형의 차수(Q), 분기별 데이터의 수(m)를 모수로 가진다. p = {1, 2, 3, 4}, d = {0, 1, 2}, q = {1, 2, 3, 4}중 아카이케정보기준(akaike information criterion, AIC)가 최소가 되는 모형을 선택합니다. 의사결정나무의 최대 깊이는 10으로 설정한다. 랜덤포레스트의 의사결정나무 수는 알고리즘의 수행 속도를 고려하여 100으로 설정한다. 신경망 방법으로 다층 퍼셉트론, 순환 신경망, 그리고 장단기 메모리를 실험하였으며, 은닉 노드의 수는 20, 윈도우 크기는 120으로 설정하였다.

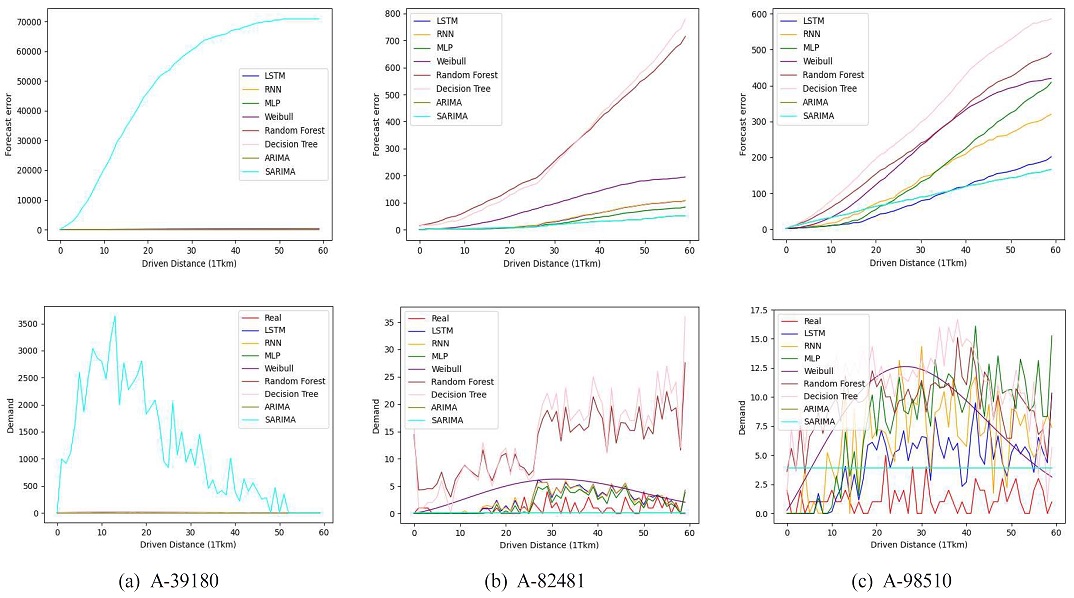

<Figure 8>의 A차종에 장착된 39180, 82481, 그리고 98510부품에 대한 구간에 따른 누적 오차와 실제 수요값과 총 8개 모형의 예측값을 나타낸다. <Figure 8(a)>에서 계절성 자기회귀누적이동평균은 과거 데이터에 대한 높은 의존성을 가지어, 특정 연식 차종의 높은 수요가 발생하였을 경우 이에 적합되어 과대 추정하는 문제점이 있다. <Figure 8(b)>, <Figure 8(c)>에서 자기회귀누적이동평균은 일정한 상수로 추정하여 오차는 적었으나, 변화하는 수요 변동을 반영하지는 못하였다. 랜덤 포레스트 성능은 의사 결정트리의 성능보다 우수하나 학습용 데이터에 과적합되어 일반화 성능이 우수하지 못하였다.

<Table 6>은 테스트 데이터에 대한 오차를 나타낸다. 장단기 메모리의 성능이 가장 우수하였으며, 자기회귀누적이동평균의 오차가 적었다. 이는 수요가 일정하게 나타나는 구간 등 특정 영역 안에서의 예측이 안정적이었으나, 변동성을 파악하진 못하였다.

4.5 전이 학습

전이학습 기반의 모형이 소규모 데이터를 가진 해당 데이터로만 학습한 모형보다 일반화 성능이 향상되었다. 원 시계열을 기반으로 상관성을 비교할 경우, 상관성이 높은 타 부품의 데이터를 확보하기 어려우므로 학습 데이터 수가 적어진다. 계절 조정 후 상관성을 비교할 경우, 상관성이 높은 타 부품의 데이터를 충분히 확보할 수 있으므로, 모형의 일반화 성능을 높일 수 있다. <Table 7>은 전이학습을 하지 않은 모형, 계절 조정 없이 전이학습한 모형 그리고 계절 조정을 활용한 전이학습 모형의 오차이다. 윈도우 크기가 60인 경우 상관성을 찾는 수요 패턴의 길이가 짧으므로, 전이학습시 오히려 오차가 증가하였습니다. 적합한 원천 도메인을 확보하는 것이 전이 학습 기반의 모형 성능에 영향을 미친다고 할 수 있다.

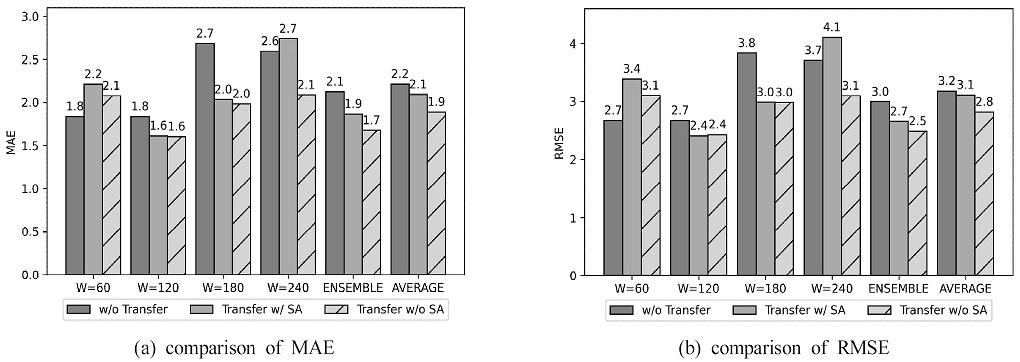

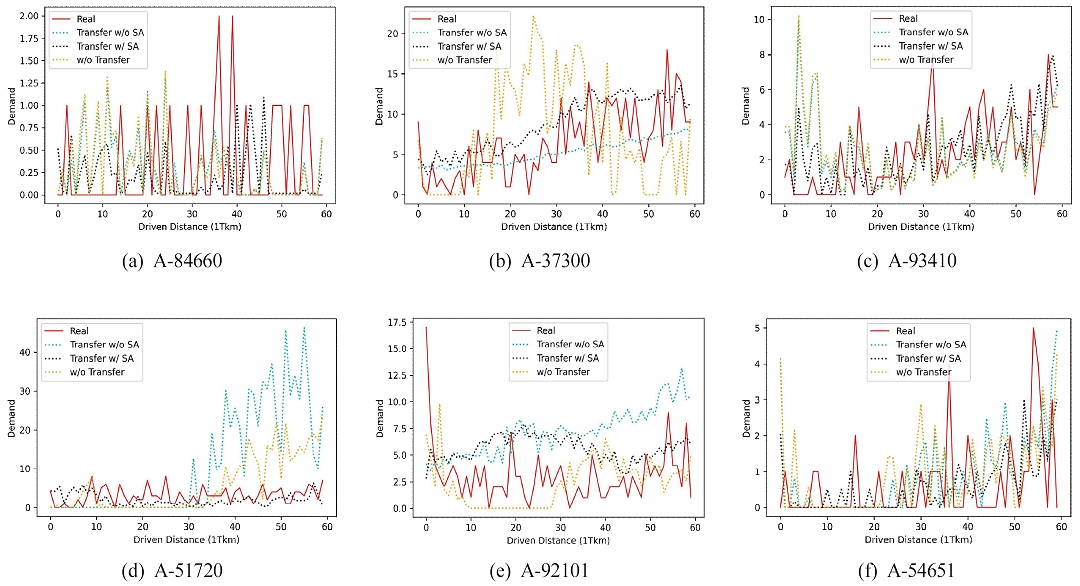

<Figure 9>는 각 윈도우 크기에 따른 전이학습을 하지 않은 모형, 계절 조정 없이 전이학습한 모형 그리고 계절 조정을 활용한 전이학습 모형의 오차를 시각화하여 보여준다. 전이학습한 모델의 오차가 MAE 기준 약 5.48%, RMSE 기준 약 2.14% 감소하였으며, 계절조정 시계열로부터 추세성분을 전이학습한 모델의 오차가 MAE 기준 약 14.85%, RMSE 기준 약 11.3% 감소하였다. <Figure 10>은 예측한 결과를 나타낸다. <Figure 10(b)>, <Figure 10(e)>에서 장기적인 추세를 따라는 것이 보이며, <Figure 10(d)>에서 다른 모형보다 이전 수요에 과적합 되지 않는 패턴을 보인다.

5. 결론 및 활용방안

본 논문에서는 계절조정을 활용한 전이학습 기반의 자동차 예비부품 장기수요예측 방법론을 제안한다. 기존 자동차 예비부품 수요예측 분야에 적용된 신경망 모형은 장기예측에 적합하며, 간헐적 수요 패턴에 우수한 성능을 보임에도, 학습 데이터의 부족 문제로 인해 실제 업무에 적용하기 어려운 경우가 많다. 전이학습은 소규모 데이터를 가진 다양한 분야에서 성공적으로 활용되고 있으나, 자동차 예비부품 수요예측모형에 적용된 연구 사례가 없다. 이에 본 논문에서는 전이학습을 사용하여 과거 데이터 자료가 충분하지 않는 자동차 예비부품 장기수요예측모형의 성능을 향상시킨다. 해당 부품만 학습한 모델보다 타 부품의 원자료를 전이학습한 모델의 오차가 MAE 기준 약 5.48%, RMSE 기준 약 2.14% 감소하였으며, 계절조정 시계열로부터 추세성분을 전이학습한 모델의 오차가 MAE 기준 약 14.85%, RMSE 기준 약 11.3% 감소하였다.

TSLF 모형은 소규모 데이터를 가진 예비부품의 장기수요를 예측한다. 예상되는 수요를 기반으로 시간이 많이 걸리는 자원을 사전에 재정비할 수 있으며, 생산라인 철수가 이뤄질 경우, 부품의 생산량과 구매량 계획 시 사용될 수 있다. 전이학습을 적용하였을 경우, 모든 조건에서 예측 성능이 향상된 것은 아니다. 장기적인 추세를 비교하지 못한 데이터가 원천 도메인으로 선택된 경우에는 오히려 예측 성능이 저하되었다. 이를 통해 원천 도메인 선택이 전이학습 모형 성능에 중요한 영향을 끼치는 것을 알 수 있다. 본 연구에서는 피어슨 상관계수를 사용하여 부품 간 상관성을 측정하였으나, 자동차 부품의 정성적 특성을 반영하거나, 상관성을 측정할 수 있는 군집 분석 등 최적의 방식을 비교하지 않는다. 향후 연구에서는 부품 간 유사성 측정 방식을 고도화하고, 다양한 원천 도메인이 전이학습 성능에 미치는 영향을 탐구하는 것이다.

Acknowledgments

이 논문은 현대자동차의 지원을 받아 수행되었음.

이 논문은 2019년도 고려대학교의 지원을 받아 수행되었음(No.K2107521, 제조 산업 데이터를 활용한 딥러닝 기반 이상 분할 탐지 기법 개발).

References

-

Al-Saba, T. and El-Amin, I. (1999), Artificial Neural Networks as Applied to Long-Term Demand Forecasting, Artificial Intelligence in Engineering, 13(2), 189-197.

[https://doi.org/10.1016/S0954-1810(98)00018-1]

- Baek, J.-J., Rhie, K. W., and Meyna, A. (2010), A Study on a Reliability Prognosis based on Censored Failure Data, Transactions of the Korean Society of Automotive Engineers, 18(1), 31-36.

-

Boylan, J. E. and Syntetos, A. A. (2009), Spare Parts Management : A Review of Forecasting Research and Extensions, IMA Journal of Management Mathematics, 21(3), 227-237.

[https://doi.org/10.1093/imaman/dpp016]

- Choi, D. W. (2014), A Data Mining Approach for Forecasting the Demand of Accidental Automobile Spare Parts with External Factors, Master’s Thesis, Yonsei University, Seoul, Korea.

-

Cohen, M. A., Agrawal, N., and Agrawal, V. (2006), Achieving Breakthrough Service Delivery Through Dynamic Asset Deployment Strategies, Interfaces, 36(3), 259-271.

[https://doi.org/10.1287/inte.1060.0212]

-

de Oliveira, E. M. and Cyrino Oliveira, F. L. (2018), Forecasting Mid-Long Term Electric Energy Consumption through Bagging ARIMA and Exponential Smoothing Methods, Energy, 144, 776-788.

[https://doi.org/10.1016/j.energy.2017.12.049]

-

Díaz-Robles, L. A., Ortega, J. C., Fu, J. S., Reed, G. D., Chow, J. C., Watson, J. G., and Moncada-Herrera, J. A. (2008), A Hybrid ARIMA and Artificial Neural Networks Model to Forecast Particulate Matter in Urban Areas : The Case of Temuco, Chile, Atmospheric Environment, 42(35), 8331-8340.

[https://doi.org/10.1016/j.atmosenv.2008.07.020]

-

Ding, Q. (2006), Long-Term Load Forecast Using Decision Tree Method, 2006 IEEE PES Power Systems Conference and Exposition.

[https://doi.org/10.1109/PSCE.2006.296529]

-

Dombi, J., Jónás, T., and Tóth, Z. E. (2018), Modeling and Long-Term Forecasting Demand in Spare Parts Logistics Businesses, International Journal of Production Economics, 201, 1-17.

[https://doi.org/10.1016/j.ijpe.2018.04.015]

-

Ghadiyaram, D., Tran, D., and Mahajan, D. (2019), Large-Scale Weakly-Supervised Pre-Training for Video Action Recognition, 2019 IEEE/ CVF Conference on Computer Vision and Pattern Recognition (CVPR).

[https://doi.org/10.1109/CVPR.2019.01232]

-

González Vargas, C. A. and Elizondo Cortés, M. (2017), Automobile Spare-Parts Forecasting : A Comparative Study of Time Series Methods, International Journal of Automotive and Mechanical Engineering, 14(1), 3898-3912.

[https://doi.org/10.15282/ijame.14.1.2017.7.0317]

- Groen, G., Jiang, S., Mosleh, A., and Droguett, E. (2004), Reliability Data Collection and Analysis System Reliability and Maintainability, 2004 Annual Symposium-RAMS, 43-48.

-

Gutierrez, R. S., Solis, A. O., and Mukhopadhyay, S. (2008), Lumpy Demand Forecasting Using Neural Networks, International Journal of Production Economics, 111(2), 409-420.

[https://doi.org/10.1016/j.ijpe.2007.01.007]

-

Ha, C. (2018), A Binomial Weighted Exponential Smoothing for Intermittent Demand Forecasting, Journal of Society of Korea Industrial and Systems Engineering, 41(1), 50-58.

[https://doi.org/10.11627/jkise.2018.41.1.050]

- Henkelmann, R. (2018), A Deep Learning Based Approach for Automotive Spare Part Demand Forecasting, Master Thesis, Otto von Guericke University Magdeburg, Magdeburg.

- Hong, J.-S., Ahn, J.-K., and Hong, S.-K. (2001), Development of the forecasting Model for Parts in an Automobile, Journal of the Korean Institute of Industrial Engineers, 27(3), 233-238.

-

Hooshmand, A. and Sharma, R. (2019), Energy Predictive Models with Limited Data using Transfer Learning, Proceedings of the Tenth ACM International Conference on Future Energy Systems, 12-16.

[https://doi.org/10.1145/3307772.3328284]

- Hyndman, R. J. and Athanasopoulos, G. (2018), Forecasting : Principles and Practice (2nd ed.), OTexts.

- Jia et al. (2018), Transfer Learning from Speaker Verification to Multispeaker Text-to-Speech Synthesis, In Proceedings of the 32nd International Conference on Neural Information Processing Systems(NIPS’18), Curran Associates Inc., Red Hook, NY, USA, 4485-4495.

- Jung, K.-S., Park, J.-S., Khan, N. T., and Kim, Y.-B. (2016), A study on Developing Forecasting Methodology for Parts Including Intermittent Demands, The Korean Operations Research and Management Science Society, 527-530.

-

Jung, S.-M., Park, S., Jung, S.-W., and Hwang, E. (2020), Monthly Electric Load Forecasting Using Transfer Learning for Smart Cities, Sustainability, 12(16), 6364.

[https://doi.org/10.3390/su12166364]

- Kang, M.-K, Kim, D.-H., and Oh, S.-J. (2014), Development of a Demand Forecasting Model for Automotive A/S Parts, Journal of the Korean Institute of Industrial Engineers, 255-271.

- Kaya, G. O. and Turkyilmaz, A. (2018), Intermittent Demand Forecasting using Data Mining Techniques, Applied Computer Science, 14(2), 38-47.

- Kim, Y. C. (2018), A Study of Demand Forecasting for Automobile Service Parts based on Data Mining Method, Thesis(Master’s) Yonsei University, Seoul, Korea.

-

Kotsialos, A., Papageorgiou, M., and Poulimenos, A. (2005), Long-Term Sales Forecasting Using Holt-Winters and Neural Network Methods, Journal of Forecasting, 24(5), 353-368.

[https://doi.org/10.1002/for.943]

-

Kourentzes, N. (2013), Intermittent Demand Forecasts with Neural Networks, International Journal of Production Economics, 143(1), 198-206.

[https://doi.org/10.1016/j.ijpe.2013.01.009]

-

Le, T., Vo, M. T., Kieu, T., Hwang, E., Rho, S., and Baik, S. W. (2020), Multiple Electric Energy Consumption Forecasting Using a Cluster-Based Strategy for Transfer Learning in Smart Building, Sensors, 20(9), 2668.

[https://doi.org/10.3390/s20092668]

-

Lee, K., Kang, D. Y., Choi, H. R., Park, B. K., Cho, M. J., and Kim, D. (2018), Intermittent Demand Forecasting with a Recurrent Neural Network Model Using IoT Data, International Journal of Control and Automation, 11(3), 153-168.

[https://doi.org/10.14257/ijca.2018.11.3.14]

-

Lee, S. and Ha, C. (2015), Long-Term Demand Forecasting Using Agent-Based Model : Application on Automotive Spare Parts, Journal of Society of Korea Industrial and Systems Engineering, 38(1), 110-117.

[https://doi.org/10.11627/jkise.2014.38.1.110]

-

Murthy, D. (2004), Product Warranty Logistics : Issues and Challenges, European Journal of Operational Research, 156(1), 110-126.

[https://doi.org/10.1016/S0377-2217(02)00912-8]

-

Nguyen, H. H. and Chan, C. W. (2004), Multiple Neural Networks for a Long Term Time Series Forecast, Neural Computing & Applications, 13(1), 90-98.

[https://doi.org/10.1007/s00521-003-0390-z]

- Oh, B.-H. and Kim, H.-C. (2017), A Study on Spare Parts Demand Forecasting Using Artificial Neural Network, Korea Information Processing Society, 824-826.

- Oliveira, M. and Torgo, L. (2015), Ensembles for Time Series Forecasting, Proceedings of the Sixth Asian Conference on Machine Learning, 360-370.

-

Pecht, M. G., Sandborn, P. A., and Solomon, R. (2000), Electronic Part Life Cycle Concepts and Obsolescence Forecasting, IEEE Transactions on Components and Packaging Technologies, 23(4), 707-717.

[https://doi.org/10.1109/6144.888857]

-

Pektas, A. O. and Cigizoglu, H. K. (2013), ANN Hybrid Model Versus ARIMA and ARIMAX Models of Runoff Coefficient, Journal of Hydrology, 500, 21-36.

[https://doi.org/10.1016/j.jhydrol.2013.07.020]

-

Ribeiro, M., Grolinger, K., ElYamany, H. F., Higashino, W. A., and Capretz, M. A. M. (2018), Transfer Learning with Seasonal and Trend Adjustment for Cross-Building Energy Forecasting, Energy and Buildings, 165, 352-363.

[https://doi.org/10.1016/j.enbuild.2018.01.034]

-

Sanh, V., Wolf, T., and Ruder, S. (2019), A Hierarchical Multi-Task Approach for Learning Embeddings from Semantic Tasks, Proceedings of the AAAI Conference on Artificial Intelligence, 33, 6949-6956.

[https://doi.org/10.1609/aaai.v33i01.33016949]

-

Sorjamaa, A., Hao, J., Reyhani, N., Ji, Y., and Lendasse, A. (2007), Methodology for Long-Term Prediction of Time Series, Neurocomputing, 70(16–18), 2861-2869.

[https://doi.org/10.1016/j.neucom.2006.06.015]

-

Toque, F., Khouadjia, M., Come, E., Trepanier, M., and Oukhellou, L. (2017), Short & Long Term Forecasting of Multimodal Transport Passenger Flows with Machine Learning Methods, 2017 IEEE 20th International Conference on Intelligent Transportation Systems(ITSC).

[https://doi.org/10.1109/ITSC.2017.8317939]

-

Torrey, L. and Shavlik, J. (2009), Transfer Learning, Handbook of Research on Machine Learning Applications and Trends, 242-264.

[https://doi.org/10.4018/978-1-60566-766-9.ch011]

-

Van der Auweraer, S., Boute, R. N., and Syntetos, A. (2017), Forecasting Spare Part Demand with Installed Base Information : A Review, SSRN Electronic Journal.

[https://doi.org/10.2139/ssrn.3104452]

- Witten, I. H., Frank, E., Hall, M. A., and Pal, C. J. (2016), Data Mining : Practical Machine Learning Tools and Techniques (Morgan Kaufmann Series in Data Management Systems) (4th ed.), Morgan Kaufmann.

- Yi, G.-S. (2017), Study of Forecasting Model Selection Methodology Based on Demand Pattern Classification of Automotive Service Parts, Korea University, Seoul, Korea.

-

Zhang, G. P. (2003), Time Series Forecasting Using a Hybrid ARIMA and Neural Network Model, Neurocomputing, 50, 159-175.

[https://doi.org/10.1016/S0925-2312(01)00702-0]

-

Zhang, G. P. and Qi, M. (2005), Neural Network Forecasting for Seasonal and Trend Time Series, European Journal of Operational Research, 160(2), 501-514.

[https://doi.org/10.1016/j.ejor.2003.08.037]

이민예 : 한동대학교 컴퓨터공학과에서 2016년 학사학위를 취득하고 고려대학교 산업경영공학부 석사과정에 재학 중이다. 연구 분야는 딥러닝, 수요 예측, 그리고 자연어 처리이다.

성기우 : 내구 데이터 분석 업무를 수행하고 있으며, 현재 사내외에 빅데이터를 활용한 기술개발을 연구 중이다.

한성원 : 고려대학교 산업 시스템 정보 공학과에서 2003년 학사학위를 취득하였다. Georgia Institute of Technology에서 2006년 Operation Research 석사학위, 2007년 Statistics 석사학위, 2010년 Mathematics 석사학위를 취득하고 2010년 Industrial Engineering과 Statistics 박사학위를 취득하였다. University of Pennsylvania, Department of Biostatistics and Epidemiology에서 Post-doctoral Researcher(2010.07~2012.06), Hoffmann-La Roche Inc., Department of Non-clinical Safety에서 Post-doctoral Fellow(2012.07~2013.08), New York University, Department of Population Health에서 Research Scientist(2013.08~2015.12), New York University, Department of Population Health에서 Senior Research Scientist (2016.01~2016.02)을 역임하고, 2016년부터 고려대학교 산업경영공학부 교수로 재직하고 있다. 연구분야 중 방법론 분야는 probabilistic graphical model, network analysis, deep learning 등이 있으며, 응용 분야로는 바이오 의료, 소재 정보학, 품질 모니터링, 텍스트 마이닝이 있다.